代码

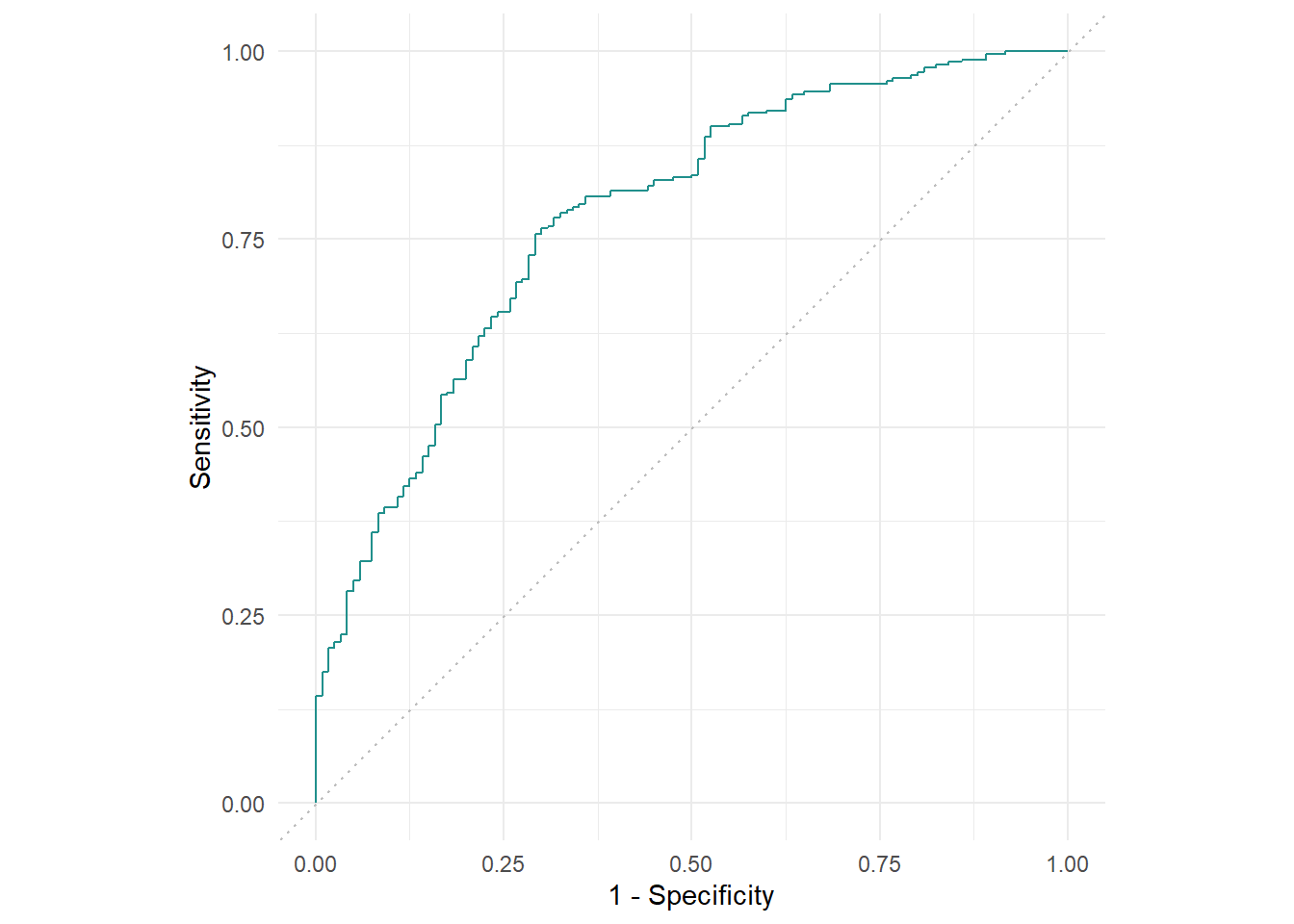

library(mlr3verse)

# 创建任务

tsk_german_credit <- tsk("german_credit")

# 选择学习器

lrn_ranger <- lrn("classif.ranger", predict_type = "prob")

# 划分训练集测试集

split <- partition(tsk_german_credit, ratio = 0.6)

lrn_ranger$train(tsk_german_credit, row_ids = split$train)

prediction <- lrn_ranger$predict(tsk_german_credit, row_ids = split$test)